In dit bericht zullen we het gaan hebben over het maken van een Zoekmachine Geoptimaliseerde Robots.txt om meer bezoekers te krijgen. Het voorbeeld dat word gebruikt in de WordPress codex is niet slecht maar ook zeker niet de beste robots.txt wat je kan gebruiken. Om het meeste uit je Robots.txt te halen zal ik hieronder uitleggen hoe je een Zoekmachine Geoptimaliseerde Robots.txt kunt maken om meer bezoekers te krijgen voor jouw WordPress website.

Wat is een Robots.txt?

Robot Exclusion Standard, die ook bekend staat als Robots Exclusion Protocol of gewoon robots.txt protocol is eigenlijk een manier om te voorkomen dat crawlers (spiders) of web-robots toegang tot een deel of heel je site hebben dat u niet geïndexeerd wil hebben of met andere woorden de delen van uw site die u niet vindbaar wilt maken in zoekmachines zoals Google, Yahoo, Bing etc.. Deze maken gebruik van robots en crawlers (spiders) om websites te scannen op keywoorden en links om ze te archiveren op hun zoekmachines zodat ze vindbaar zijn voor het publiek.

Hoe Helpt de Robots.txt jou Website?

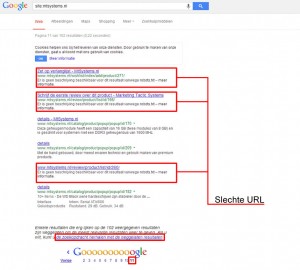

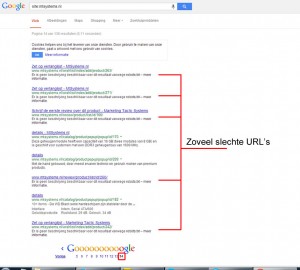

Met dit bestand kunt u controle krijgen over robots en de crawlers (spiders). Dus nu kunt u zoekmachine robots en spiders beheersen en controleren dat ze alleen delen van uw website indexeren die u wilt dat die geïndexeerd worden. Stel maar eens voor je zoekt via een zoekmachine je WordPress website op en je ziet dan ineens links naar je wp-admin bestanden staan? Dat wil je natuurlijk niet en zo is dat ook met persoonlijke bestanden deze moeten niet geïndexeerd worden door een zoekmachine zoals Google. Zo meteen laat ik zien hoe je de Zoekmachine Geoptimaliseerde Robots.txt kan maken en kan aanpassen zodat je Google PageRank zal stijgen door betere keywords indexatie en dat zal uiteindelijk leiden tot meer bezoekers.

Zoekmachine Geoptimaliseerde Robots.txt voor WordPress Maken.

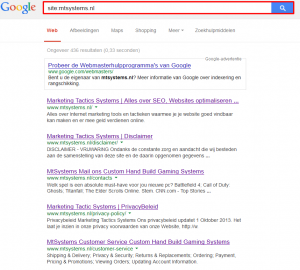

Normaal gesproken staat de Robots.txt in de hoofdmap van je website zoals http://www.jouwwebsiteurl.nl/robots.txt dit bestand kan je zelf maken in een tekst editor of door gebruik te maken van een WordPress plugin net als wij hebben gedaan dit is erg makkelijk en je kan de robots.txt bewerken via de WordPress backend je kan mijn robots.txt bekijken via http://www.mtsystems.nl/robots.txt. Die van u zal er nu anders eruit zien als die van mij maar het zal straks lijken op van die van mij.

Installeren van Robot.txt plugin voor WordPress

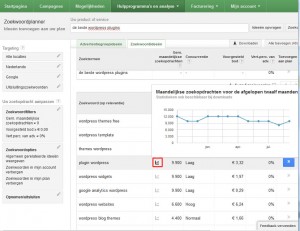

- Om te beginnen ga je naar je backend van je WordPress website en klik op Plugins->Nieuwe Plugin en zoek daar naar “pc robots.txt” zoals in de afbeelding hieronder en installeer dit en activeer de plugin.

- Ga dan naar Instellingen->PC Robots.txt verwijder alles wat er in het invul blok staat en plaats de volgende tekst die ik hieronder geplaatst heb in dat blok en daarna “Save Changes”.

User-agent: *

Disallow: /cgi-bin/

Disallow: /wp-admin/

Disallow: /wp-content/

Disallow: /wp-includes/

Disallow: /recommended/

Disallow: /comments/feed/

Disallow: /trackback/

Disallow: /index.php

Disallow: /xmlrpc.php

Disallow: /wp-content/plugins/

Disallow: /wp-login.php

Disallow: /wp-register.php

User-agent: NinjaBot

Allow: /

User-agent: Mediapartners-Google*

Allow: /

User-agent: Googlebot-Image

Allow: /wp-content/uploads/

User-agent: Adsbot-Google

Allow: /

User-agent: Googlebot-Mobile

Allow: /

User-agent: Alexibot

User-agent: Aqua_Products

User-agent: asterias

User-agent: b2w/0.1

User-agent: BackDoorBot/1.0

User-agent: BlowFish/1.0

User-agent: Bookmark search tool

User-agent: BotALot

User-agent: BotRightHere

User-agent: BuiltBotTough

User-agent: BunnySlippers

User-agent: CheeseBot

User-agent: CherryPicker

User-agent: CherryPickerElite/1.0

User-agent: CherryPickerSE/1.0

User-agent: Copernic

User-agent: CopyRightCheck

User-agent: cosmos

User-agent: Crescent Internet ToolPak HTTP OLE Control v.1.0

User-agent: Crescent

User-agent: DittoSpyder

User-agent: EmailCollector

User-agent: EmailSiphon

User-agent: EmailWolf

User-agent: EroCrawler

User-agent: ExtractorPro

User-agent: FairAd Client

User-agent: Flaming AttackBot

User-agent: Foobot

User-agent: Gaisbot

User-agent: GetRight/4.2

User-agent: Harvest/1.5

User-agent: hloader

User-agent: httplib

User-agent: HTTrack 3.0

User-agent: humanlinks

User-agent: InfoNaviRobot

User-agent: Iron33/1.0.2

User-agent: JennyBot

User-agent: Kenjin Spider

User-agent: Keyword Density/0.9

User-agent: larbin

User-agent: LexiBot

User-agent: libWeb/clsHTTP

User-agent: LinkextractorPro

User-agent: LinkScan/8.1a Unix

User-agent: LinkWalker

User-agent: LNSpiderguy

User-agent: lwp-trivial/1.34

User-agent: lwp-trivial

User-agent: Mata Hari

User-agent: Microsoft URL Control – 5.01.4511

User-agent: Microsoft URL Control – 6.00.8169

User-agent: Microsoft URL Control

User-agent: MIIxpc/4.2

User-agent: MIIxpc

User-agent: Mister PiX

User-agent: moget/2.1

User-agent: moget

User-agent: Mozilla/4.0 (compatible; BullsEye; Windows 95)

User-agent: MSIECrawler

User-agent: NetAnts

User-agent: NICErsPRO

User-agent: Offline Explorer

User-agent: Openbot

User-agent: Openfind data gatherer

User-agent: Openfind

User-agent: Oracle Ultra Search

User-agent: PerMan

User-agent: ProPowerBot/2.14

User-agent: ProWebWalker

User-agent: psbot

User-agent: Python-urllib

User-agent: QueryN Metasearch

User-agent: Radiation Retriever 1.1

User-agent: RepoMonkey Bait & Tackle/v1.01

User-agent: RepoMonkey

User-agent: RMA

User-agent: searchpreview

User-agent: SiteSnagger

User-agent: SpankBot

User-agent: spanner

User-agent: suzuran

User-agent: Szukacz/1.4

User-agent: Teleport

User-agent: TeleportPro

User-agent: Telesoft

User-agent: The Intraformant

User-agent: TheNomad

User-agent: TightTwatBot

User-agent: toCrawl/UrlDispatcher

User-agent: True_Robot/1.0

User-agent: True_Robot

User-agent: turingos

User-agent: TurnitinBot/1.5

User-agent: TurnitinBot

User-agent: URL Control

User-agent: URL_Spider_Pro

User-agent: URLy Warning

User-agent: VCI WebViewer VCI WebViewer Win32

User-agent: VCI

User-agent: Web Image Collector

User-agent: WebAuto

User-agent: WebBandit/3.50

User-agent: WebBandit

User-agent: WebCapture 2.0

User-agent: WebCopier v.2.2

User-agent: WebCopier v3.2a

User-agent: WebCopier

User-agent: WebEnhancer

User-agent: WebSauger

User-agent: Website Quester

User-agent: Webster Pro

User-agent: WebStripper

User-agent: WebZip/4.0

User-agent: WebZIP/4.21

User-agent: WebZIP/5.0

User-agent: WebZip

User-agent: Wget/1.5.3

User-agent: Wget/1.6

User-agent: Wget

User-agent: wget

User-agent: WWW-Collector-E

User-agent: Xenu’s Link Sleuth 1.1c

User-agent: Xenu’s

User-agent: Zeus 32297 Webster Pro V2.9 Win32

User-agent: Zeus Link Scout

User-agent: Zeus

Disallow: /

- Ga na het opslaan van je Robots.txt naar je link om te kijken of alles er staat zoals http://www.jouwebsiteurl.nl/robots.txt.

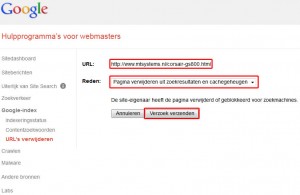

Nu heb je een Zoekmachine Geoptimaliseerde Robots.txt gemaakt en zullen er geen slechte links en geen links geïndexeerd worden die jij niet wilt als er links geïndexeerd zijn die je niet wilt hebben dan kan je deze verwijderen via je Google Webmaster Tools. Dit zal ik binnenkort bespreken hoe dat moet! Heb je hier iets op aan te merken of te vragen stel ze dan gerust hieronder als reactie.